İngiltere merkezli İnternet İzleme Vakfı (IWF) yayınladığı son raporda, hükümetleri ve teknoloji sağlayıcılarını, yapay zeka tarafından üretilen çocuk cinsel istismarı görüntülerine karşı uyardı. Vakıf, bu tür görüntülerin potansiyel kurban havuzunu daha fazla genişletmesine izin verilmeden, yapay zeka araçlarının kontrol altına alınması çağrısı yaptı.

İzleme grubunun baş teknoloji sorumlusu Dan Sexton, "Bunun verebileceği zarardan bahsetmiyoruz. Bu şimdiden yaşanıyor ve hemen şimdi ele alınması gerekiyor" dedi.

Sexton, IWF analistlerinin internette ünlü çocukların yüzlerinin yanısıra "muhtemelen yıllar önce istismara uğramış çocukların daha fazla görüntüsünün yaratılması için büyük bir talep" keşfettiklerini söyledi.

IWF yetkilisi, "Mevcut gerçek içeriği alıyorlar ve bunu bu kurbanların yeni içeriğini oluşturmak için kullanıyorlar. Bu inanılmaz derecede şok edici" dedi.

Güney Kore'de türünün ilk örneği olan davada bir adam Eylül ayında yapay zeka kullanarak 360 sanal çocuk istismarı görüntüsü oluşturmaktan 2,5 yıl hapis cezasına çarptırıldı.

Bazı durumlarda çocuklar bu araçları birbirleri üzerinde kullanıyor. İspanya'nın güneybatısındaki bir okulda polis, gençlerin tamamen giyinik okul arkadaşlarını fotoğraflarda çıplak göstermek için bir telefon uygulaması kullandıkları iddiasını araştırıyor.

Rapor, kullanıcıların e-postalardan yeni sanat eserlerine veya videolara kadar ne üretmek istediklerini kelimelerle tanımlamalarını ve sistemin bunu ortaya çıkarmasını sağlayan üretken yapay zeka sistemleri oluşturma yarışının, karanlık tarafını ortaya koyuyor.

Eğer durdurulamazsa, deepfake çocuk cinsel istismarı görüntüleri, sanal karakterlere dönüşen çocukları kurtarmaya çalışan araştırmacıları batağa saplayabilir. Failler bu görüntüleri yeni kurbanlar bulmak ve onları zorlamak için de kullanabilir.

Sexton, çevrimiçi çocuk cinsel istismarıyla mücadeleye odaklanan yardım kuruluşunun ilk olarak bu yılın başlarında yapay zeka tarafından üretilen istismarcı görüntülerle ilgili raporlar almaya başladığını söyledi.

Bunun üzerine, internetin şifreli bir ağ içinde barındırılan ve yalnızca anonimlik sağlayan araçlarla erişilebilen bir bölümü olan ‘dark web’deki forumlar araştırılmaya başlandı.

IWF analistleri, ev bilgisayarlarını her yaştan çocuğun cinsel içerikli görüntülerini üretmek için fabrikalara dönüştürmenin ne kadar kolay olduğuyla ilgili yöntemlerin ‘dark web’de paylaşan pedofilleri buldu. Bazı kullanıcılar, giderek daha gerçekçi görünen bu görüntülerin ticaretini bile yapıyordu.

Rapora göre çocuk oyuncuların görselleri, cinsel hale sokulacak şekilde manipüle ediliyor. Analistler, çoğunlukla kadın şarkıcıların ve film yıldızlarının, görüntüleme yazılımı kullanılarak çocuk gibi görünmeleri için yaşlarının küçültüldüğü resimler de buldu.

Sexton, bu nedenle içerik patlaması yaşandığını kaydetti.

Büyüyen bir soruna işaret eden IWF raporu, hükümetleri yapay zeka tarafından üretilen istismarla mücadeleyi kolaylaştırmak için yasaları güçlendirmeye çağırıyor. Rapor özellikle, daha önce güvenlik güçlerince bilinmese bile, mesajlaşma uygulamalarını şüpheli çocuk cinsel istismarı görüntüleri için otomatik olarak tarayabilecek gözetim önlemleri konusunda tartışmaların yaşandığı Avrupa Birliği'ni hedef alıyor.

Grubun çalışmalarının önemli bir odağı, daha önce cinsel istismara uğramış mağdurların fotoğraflarının yayılması yoluyla tekrar istismara uğramalarını önlemek.

Yeni yapay zeka görüntü oluşturucuları geçen yıl tanıtıldı ve komut üzerine tuhaf veya gerçekçi görüntüler oluşturma yetenekleriyle kamuoyunu şaşırttı. Ancak bunların çoğu, çocuk cinsel istismarı için materyal üretenlerce tercih edilmiyor; çünkü bunu engelleyecek mekanizmalar içeriyorlar.

Sexton, nasıl eğitildikleri ve kullanıldıkları üzerinde tam kontrol olan kapalı yapay zeka modellerine sahip teknoloji sağlayıcılarının, kötüye kullanımı engellemede daha başarılı göründüğünü belirtiyor. OpenAI'ın görüntü oluşturucusu DALL-E, bunun bir örneği.

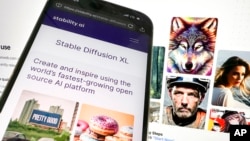

Buna karşılık, çocuk istismarcılarının tercih ettiği bir araç, Londra merkezli startup Stability AI tarafından geliştirilen açık kaynaklı Stable Diffusion.

Stable Diffusion 2022 yazında sahneye çıktığında, bir grup kullanıcı, çıplaklık ve pornografi üretmek için onu nasıl kullanacaklarını çabucak öğrendi. Bu materyallerin çoğu yetişkinleri tasvir etse de ünlülerden esinlenen çıplak resimler oluşturmak için kullanıldığında olduğu gibi, genellikle rıza dışıydı.

Stability daha sonra güvenli olmayan ve uygunsuz içeriği engelleyen yeni filtreler uygulamaya koydu. Stability'nin yazılımını kullanma lisansı aynı zamanda yasadışı kullanım yasağını da beraberinde getiriyor.

Sorunu inceleyen bir başka gözlemci grup olan Stanford Internet Observatory'nin baş teknoloji uzmanı David Thiel ise kullanıcıların Stable Diffusion'ın filtrelenmemiş eski sürümlerine hala erişebildiklerini, bu sürümlerim "çocukları içeren müstehcen içerik oluşturan kişiler için ezici çoğunlukla tercih edilen yazılım" olduğunu söyledi.

Yapay zeka tarafından üretilen çocuk cinsel istismarı görüntülerinin çoğu ABD, İngiltere ve diğer ülkelerdeki mevcut yasalar uyarınca yasadışı kabul edilebilir; ancak güvenlik güçlerinin bu tür içeriklerle mücadele edecek araçlara sahip olup olmadığı henüz belli değil.

IWF'in raporu, gelecek hafta İngiltere hükümetinin evsahipliğinde düzenlenecek ve aralarında ABD Başkan Yardımcısı Kamala Harris ve teknoloji liderleri gibi yüksek profilli katılımcıların yer alacağı küresel bir yapay zeka güvenlik toplantısı öncesinde yayınlandı.

Forum